Cara Atasi "Failed: Robots.txt Unreachable" dengan Mudah dan Cepat

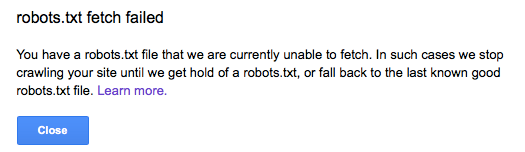

Cara Atasi "Failed: Robots.txt Unreachable" dengan Mudah dan Cepat - Ketika pertama kali melihat error "Failed: Robots.txt Unreachable" di Google Search Console, saya sempat panik. Apa yang salah? Apakah website saya akan terpengaruh? Bagaimana pengunjung akan menemukan halaman saya di mesin pencari?

Setelah sedikit riset dan mencoba berbagai solusi, akhirnya saya menemukan cara untuk mengatasi masalah ini.

Dalam artikel ini, saya akan membagikan pengalaman saya dan langkah-langkah mudah yang bisa kamu ikuti untuk mengatasi error tersebut.

Baca Juga Cara Mengganti Template Blog Agar Visitor/Pengunjung Blog Tidak Turun

Apa Itu Failed: Robots.txt Unreachable?

Sebelum kita membahas cara mengatasinya, penting untuk memahami apa itu error "Failed: Robots.txt Unreachable".

File *robots.txt* adalah file penting yang memberi instruksi kepada mesin pencari tentang halaman mana yang boleh atau tidak boleh mereka indeks.

Jika file ini tidak dapat diakses oleh Googlebot (atau bot mesin pencari lainnya), maka mereka mungkin tidak dapat mengindeks website kamu dengan benar.

Error ini biasanya muncul di Google Search Console saat Google mencoba mengakses file *robots.txt* milikmu, tetapi gagal.

Dampaknya bisa serius, mulai dari pengindeksan yang terganggu hingga penurunan performa SEO.

Bayangkan jika halaman penting di website-mu tidak muncul di hasil pencarian karena Google tidak bisa memahami apa yang harus dilakukan dengan situsmu.

Penyebab Robots.txt Unreachable

Ada beberapa hal yang dapat menyebabkan error ini. Berikut adalah beberapa penyebab yang saya temukan:

Masalah Server

Ini adalah salah satu penyebab paling umum. Jika servermu sedang mengalami downtime atau kelebihan beban, file *robots.txt* tidak akan bisa diakses oleh Googlebot.

Kesalahan Konfigurasi File Robots.txt

Kesalahan dalam format atau isi file *robots.txt* juga bisa menjadi penyebab masalah. Misalnya, file tersebut mungkin tidak memiliki izin yang benar atau tidak berada di lokasi yang tepat.

Firewall atau Pengaturan Keamanan

Kadang, pengaturan keamanan di server atau hosting dapat secara tidak sengaja memblokir Googlebot.

Kesalahan DNS atau Koneksi Jaringan

Jika ada masalah dengan DNS atau koneksi jaringan antara servermu dan Google, maka file *robots.txt* tidak akan bisa diakses.

Setelah mengetahui penyebabnya, saya mulai mencoba langkah-langkah berikut untuk mengatasinya.

Cara Atasi Failed: Robots.txt Unreachable

Berikut adalah langkah-langkah yang saya lakukan untuk memperbaiki masalah ini. Kamu juga bisa mencobanya satu per satu sampai error tersebut teratasi.

Periksa Status Server Website

Langkah pertama yang saya lakukan adalah memastikan bahwa server tempat website saya di-hosting tidak mengalami masalah.

Saya menggunakan alat seperti *Pingdom* dan *Uptime Robot* untuk memantau server. Jika server sedang offline atau mengalami downtime, maka itu adalah penyebabnya.

Solusinya? Hubungi penyedia hosting dan pastikan mereka memperbaiki masalahnya secepat mungkin.

Periksa Akses ke File Robots.txt

Selanjutnya, saya mencoba mengakses file *robots.txt* melalui browser. Caranya mudah, cukup buka `https://www.websiteanda.com/robots.txt`.

Jika file tersebut bisa diakses tanpa masalah, berarti error bukan berasal dari file itu sendiri. Namun, jika file tidak ditemukan atau muncul error, saya tahu harus memeriksa lebih dalam.

Perbaiki Konfigurasi File Robots.txt

Saya kemudian memeriksa isi file *robots.txt* untuk memastikan formatnya benar. Contoh file sederhana yang saya gunakan adalah:

```

User-agent: *

Disallow:

```

File ini memberikan akses penuh kepada semua bot mesin pencari. Jangan lupa untuk memvalidasi file *robots.txt* menggunakan alat seperti Google Robots Testing Tool untuk memastikan tidak ada kesalahan.

Baca Juga Cara Setting Robots.txt Khusus Blogger Dan Penjelasannya

Cek Pengaturan Firewall dan Keamanan

Pengaturan keamanan di server saya ternyata secara tidak sengaja memblokir akses Googlebot. Saya memperbaikinya dengan memastikan bahwa IP Googlebot tidak diblokir. Kamu bisa menemukan daftar IP Googlebot di dokumentasi resmi Google dan menambahkannya ke dalam whitelist.

Periksa DNS dan Koneksi Jaringan

Setelah itu, saya memeriksa pengaturan DNS dan memastikan semuanya sudah benar. Jangan lupa untuk memeriksa konfigurasi SSL jika website kamu menggunakan HTTPS, karena masalah sertifikat juga bisa menjadi penyebab file tidak dapat diakses.

Karena saya menggunakan DNS cloudflare, maka salah satu penyebab saya mendapatkan pesan Failed: Robots.txt Unreachable adalah dikarenkan DNS tersebut.

Di sarankan untuk pengecekan kembali DNS Cloudflare atau kamu bisa menggunakan DNS lokas server yang kamu pergunakan.

Laporkan ke Google Jika Diperlukan

Jika semua langkah di atas sudah dilakukan tetapi error masih muncul, saya sarankan untuk menggunakan fitur "Test Live" di Google Search Console. Kamu juga bisa mengirimkan ulang file *robots.txt* agar Google mencoba mengaksesnya kembali.

Tips Mencegah Error 'Robots.txt Unreachable' di Masa Depan

Dari pengalaman saya, pencegahan adalah kunci untuk menghindari masalah ini di masa depan. Berikut beberapa hal yang bisa kamu lakukan:

Selalu Monitor Kesehatan Server

Pastikan server kamu selalu online dengan menggunakan alat monitoring seperti *Pingdom*. Ini akan memberimu notifikasi jika ada downtime.

Lakukan Pengecekan Berkala pada File Robots.txt

Jadwalkan pengecekan rutin untuk memastikan file *robots.txt* masih berada di lokasi yang tepat dan dapat diakses.

Optimalkan Pengaturan Keamanan

Pastikan firewall atau pengaturan keamanan tidak menghalangi akses untuk bot mesin pencari. Selalu update whitelist jika ada perubahan IP dari Googlebot.

Gunakan Alat Monitoring Website

Alat monitoring website dapat membantumu mendeteksi masalah sejak dini, termasuk jika file *robots.txt* tidak dapat diakses.

Mengatasi error "Failed: Robots.txt Unreachable" memang bisa terasa menakutkan di awal, tetapi dengan langkah-langkah yang tepat, kamu pasti bisa memperbaikinya dengan mudah dan cepat.

Pastikan kamu selalu memantau kesehatan website dan memperbarui pengaturan sesuai kebutuhan.

Setelah menyelesaikan semua langkah ini, saya merasa lega karena website saya kembali normal.

Halaman-halaman penting saya sudah bisa diindeks oleh Google, dan performa SEO saya tetap terjaga.

Jangan lupa untuk segera cek kondisi file *robots.txt* di website-mu sekarang. Semoga artikel ini bermanfaat dan bisa menjadi referensi untukmu!

0 Response to "Cara Atasi "Failed: Robots.txt Unreachable" dengan Mudah dan Cepat"

Post a Comment

Jangan lupa komentar ya